파라미터

학습 과정 중에 끊임없이 변경되어 가면서 퍼셉트론의 동작 특정을 결정하는 값들을 파라미터라고 한다.

- 가중치

- 편향

결국 딥러닝 학습 목표는 문제 풀이에 적합한 파라미터 값의 조합을 구하는 것이다.

텐서

다차원 숫자 배열

딥러닝에서 텐서가 중요한 이유는 반복문 대신 텐서를 이용해 처리하는 편이 프로그램도 간단하고 처리속도도 높기 때문 (파이썬 인터프리터가 반복문보다 텐서 연산을 더 효육적으로 처리)

미니배치

신경망이 여러 데이터를 한꺼번에 처리하는 것

데이터 처리의 효율을 높여주며 개별 학습 데이터의 특징을 무시하지 않으면서 특징에 너무 휘둘리지 않게 해줌

에포크

학습 데이터 전체에 대한 한 차례 처리

하이퍼 파라미터

에포크 수나 미니배치 크기처럼 학습 과정에서 변경되지 않으면서 신경망 구조나 학습 결과에 영향을 미치는 고려 요인

KONANtechnology/Academy.ALZZA

교재 연습을 위한 자료를 다운받으실 수 있습니다. . Contribute to KONANtechnology/Academy.ALZZA development by creating an account on GitHub.

github.com

파라미터별 학습결과

모델1

- learning rate: 0.01

- mb_size: 100

- epoch: 100

데이터 정확도: 81.8%

결과화면

모델2

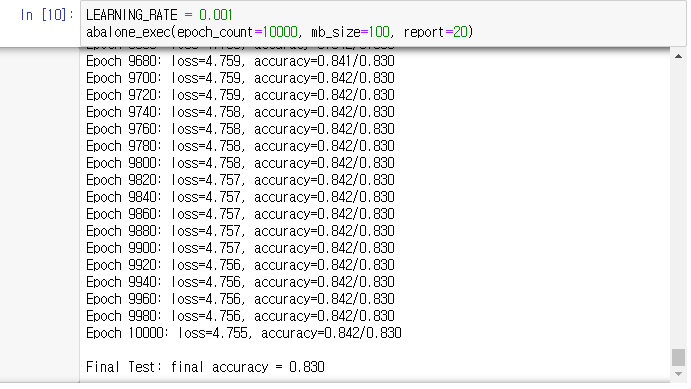

- learning rate: 0.001

- mb_size: 100

- epoch: 10000

데이터 정확도: 83.0%

결과화면

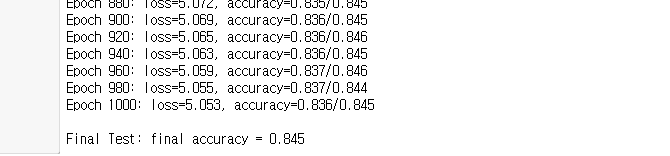

모델3

- learning rate: 0.01

- mb_size: 100

- epoch: 1000

데이터 정확도: 84.8%

결과화면

모델4

- learning rate: 0.001

- mb_size: 10

- epoch: 5000

데이터 정확도: 83.5%

결과화면

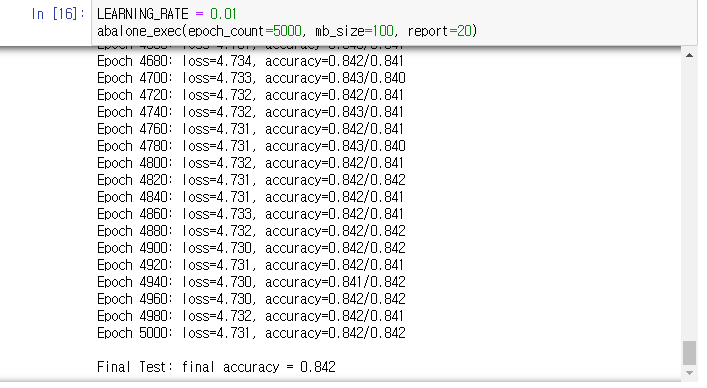

모델5

- learning rate: 0.01

- mb_size: 100

- epoch: 5000

데이터 정확도: 84.2%

결과화면

모델6

- learning rate: 0.1

- mb_size: 100

- epoch: 5000

데이터 정확도: 85.0%

결과화면

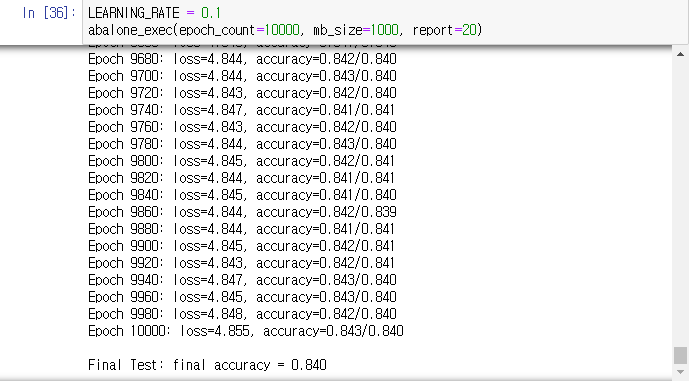

모델7

- learning rate: 0.1

- mb_size: 1000

- epoch: 10000

데이터 정확도: 84.0%

결과화면

모델8

- learning rate: 0.1

- mb_size: 10

- epoch: 100

데이터 정확도: 84.9%

결과화면

미니배치 100에 에폭5000, 학습률 0.1이 85%의 정확도로 제일 높았다. 이후 에폭만 증가시켜 학습을 다시 진행했지만 84퍼센트의 정확도로 감소하는 것으로 보아 오버피팅이 발생한 것으로 생각된다.

| 구분 | 모델1 | 모델2 | 모델3 | 모델4 | 모델5 | 모델6 | 모델7 | 모델8 |

| 정확도 | 81.8% | 83.0% | 84.8% | 83.5% | 84.2% | 85.0% | 84.0% | 84.9% |

| 순위 | 8 | 7 | 3 | 6 | 4 | 1 | 5 | 2 |

'Computer Science > AI' 카테고리의 다른 글

| 천체의 펄서 예측 신경망 (0) | 2020.09.28 |

|---|---|

| 회귀분석: 전복의 고리 수 추정 신경망 (0) | 2020.09.16 |

| XOR을 위한 다층 퍼셉트론 (0) | 2020.09.11 |

| 인공지능 개론 (2) | 2020.09.02 |

댓글